Google hat ein hilfreiches Content-Update auf den Weg gebracht, und viele Publisher sind zu Recht nervös, wie es sich auf ihre Webseite auswirken könnte. Was passiert, wenn sich das Google-Update negativ auf den Traffic ihrer Webseite auswirkt?

Ich habe viel Zeit damit verbracht, dies zu analysieren und zu bewerten, und ich möchte mit Ihnen einige der wichtigsten Verhaltensweisen und Strategien teilen, die ein Publisher tun kann, um sicherzustellen, dass seine Webseite dieses neue hilfreiche Content-Update von Google nicht nur überlebt, sondern gedeiht.

Zunächst einmal müssen wir die wirklichen Probleme der Publisher verstehen und wissen, wer Google wirklich ist.

Denken Sie daran, dass Google zwar ein gigantisches Unternehmen ist, aber die Zusammenarbeit zwischen den einzelnen Teams, insbesondere dem Suchteam (dem Team, das den Suchmaschinenalgorithmus verwaltet und pflegt), ist sehr gering. Und warum? Google ist zu Recht sehr wählerisch, was die rechtlichen Konsequenzen der Interaktion des Suchteams mit anderen Google-Teammitgliedern angeht. Das Suchteam ist buchstäblich die Abteilung, die die KI und den Suchalgorithmus von Google verwaltet, den Algorithmus, der den organischen Traffic für 87 % aller Suchmaschinenanfragen weltweit bestimmt. Google möchte nicht, dass dieses Team versehentlich Geheimnisse weitergibt oder sogar unbeabsichtigt falsche Vorstellungen über die Logik und die Verfahren des Suchteams vermittelt.

Das hat allerdings auch seine Nachteile. Vor fünf Jahren glaubte Google, dass die organischen Suchergebnisse zu 100 % maschinengesteuert sein würden. Leider haben diese maschinengesteuerten algorithmischen Prozesse zu einem Zustrom von SEO-Templates geführt, die von Content Creatorn veröffentlicht werden, die versuchen, das zu erreichen, was Google ihrer Meinung nach will, und dabei das Nutzererlebnis durch die von den Nutzern verabscheuten Cookie-Vorlagen stark einschränken.

Anstatt zu versuchen, die neuesten SEO-Vorlagen zu entwickeln, die von SEO-“Experten” propagiert werden, müssen Sie sich nur auf ein großes, übergreifendes Ziel konzentrieren: wirklich gute Inhalte zu erstellen, die Ihr Publikum wirklich mag.

Lassen Sie uns über die Bereitstellung wesentlicher Informationen sprechen. Was wir bei Ezoic festgestellt haben und was auch von Googles Marketing und Nachrichten unterstützt wird, ist, dass Nutzer, die von einer Suchergebnisseite abspringen und verschwinden, in den Augen von Google für die meisten Suchanfragen positiv sind. Google sieht Nutzer, die zu viel Zeit auf Webseiten und Suchergebnisseiten verbringen, als sehr negativ an. Wenn ein Nutzer viel Zeit damit verbringen muss, sich durch nutzlose Daten und unzusammenhängende Inhalte zu wühlen, deutet dies auf eine minderwertige Webseite hin, die keinen größeren Traffic verdient.

Webseiten und Publisher werden die Dinge nie so sehen, wie Google es tut. Während Publisher von SEO, Keywords und h2-Headern besessen sind, achtet Google sehr genau auf andere, weniger offensichtliche Suchergebnis-Metriken wie Nutzer-Ergebniszeiten, Anzahl der aufeinanderfolgenden Suchanfragen, verwandte, themenbezogene Suchanfragen und Rückkehr zur Ergebnisseite.

Im Grunde genommen verschwenden die meisten Webseiten, die sich über Nutzererlebnisse Gedanken machen, nur ihre Zeit. Was wir bei Ezoic beobachtet haben (und was später von Google bestätigt wurde), ist, dass die Sitzungsdauer und die Absprungrate oft “schlecht” sind (längere Sitzungen und geringere Absprungrate), was im Wesentlichen darauf hindeutet, dass eine Webseite unwichtige Informationen liefert. Aus der Sicht von Google ist es ein gutes Zeichen, dass ein Nutzer möglicherweise kürzere Sessions auf einer Webseite hat und eine schnellere Absprungrate, was bedeuten kann, dass ein Nutzer schnell genau das gefunden hat, wonach er gesucht hat – ohne sich durch unzusammenhängende Daten zu wühlen oder durch ein verwirrendes Labyrinth von SEO-Vorlagen zu navigieren.

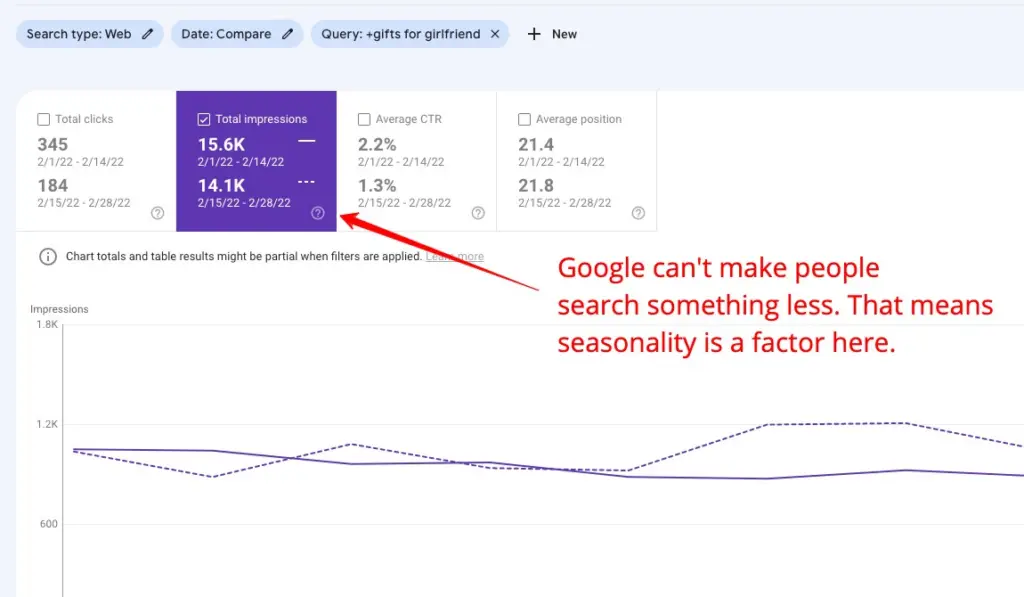

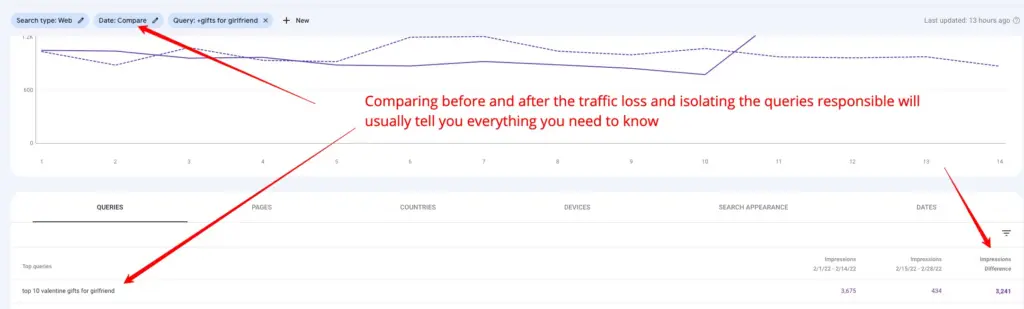

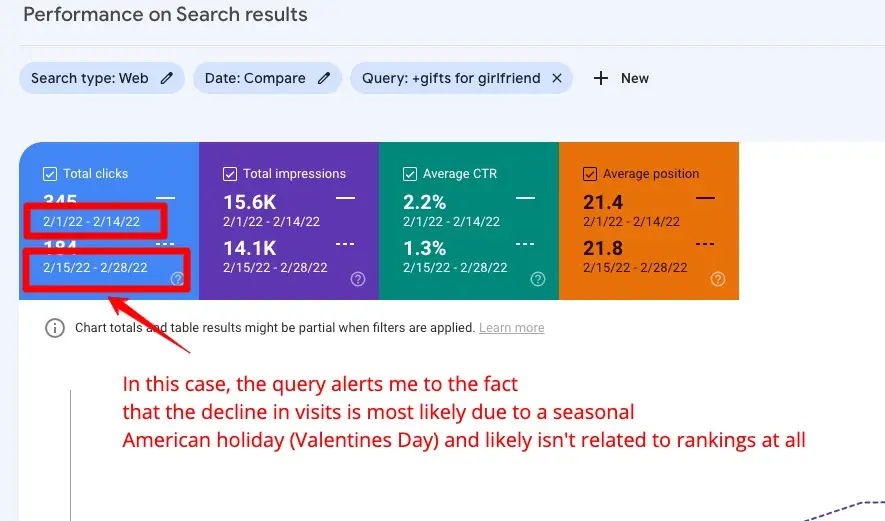

In dieser kurzen Anleitung erfahren Sie, wie Sie mit der Google Search Console herausfinden können, warum der organische Traffic auf einer Webseite zu- oder abnimmt:

Google versucht, Webseiten zu entwerten, die versuchen, breit angelegte Keywords in lange Artikel zu packen, während der Nutzer eine Antwort auf eine Anfrage sucht, die vielleicht nur 500 Wörter oder weniger benötigt. Hier handelt es sich um die nächste Stufe der Content-Erstellung, bei der der Publisher die Kunst perfektioniert hat, seinem Publikum genau die Inhalte zu liefern, die es braucht. Der Inhalt ist nicht aufgebauscht, übertrieben oder unnötig lang, um eine vermeintliche SEO-Bedeutung zu erzielen – es handelt sich einfach um hervorragende Inhalte, die genau das erreichen, was sie sollen.

Es gibt eine Menge Google-Daten, die dies belegen. Viele von Ihnen wissen vielleicht, dass ein Hack für SEO in den letzten Jahren die Assoziation von Keywords mit Entitäten war – im Wesentlichen die Verwendung von Googles öffentlichen Google-Trends-Daten, um alle assoziierten Begriffe und Themen für ein Keyword zu hacken und zu entdecken, um ein Thema zu “überdecken” und zu versuchen, mehr organischen Traffic zu generieren (z. B. “Arnold Schwarzenegger”, “California Governor”, “Predator” usw.). Dies war vielen nicht bekannt, aber die Technik der Überdeckung von Themen wurde zu einer von SEO-Fachleuten befürworteten Technik, die den zugrundeliegenden Mechanismus nicht verstanden und oft ihre eigenen dummen Ideen dafür einbrachten, warum dies geschah.

Das Ergebnis? Minderwertige Inhalte, die den Nutzern sehr missfielen. Als sie auf diese Flut von minderwertigen Inhalten in Rankings trafen, die übermäßig breite und lange Artikel betonten, gaben die Nutzer stattdessen oft Suchanfragen mit Antworten wie “lebt Arnold Schwarzenegger REDDIT” ein; was sie als Mittel sahen, um Antworten anderswo zu finden, da Google schlechte Erfahrungen bot.

Mit diesem hilfreichen Inhaltsupdate sollen Webseiten belohnt werden, die prägnante und nutzerorientierte Antworten geben.

Ein weiterer Aspekt dieser Diskussion ist das Aufkommen von mit künstlicher Intelligenz erstellten Inhalten, ein massiver Trend, der gerade erst begonnen hat, sich durchzusetzen. Publisher wollen wissen, wie künstliche Intelligenz ihrer Webseite helfen kann und wie diese Art von Inhalten mit SEO zusammenhängt.

Dies ist der Grund, warum KI nicht die Inhalte schreiben kann, die Google bewerten möchte.

Nehmen wir an, Sie suchen nach “wie man ein weinendes Baby beruhigt”. Die künstliche Intelligenz kann einen Artikel über “warum Babys weinen” schreiben, der wahrscheinlich nur eine Aufzählung ist, die leicht zu einem guten Ergebnis führen könnte. Publisher werden dafür nicht benötigt. Aber WIE man ein schreiendes Baby zum Schweigen bringt, ist ein Inhalt, der am besten von jemandem mit Fachwissen vermittelt wird, und KI kann diese direkte und menschliche Information nicht liefern – und wenn sie es täte, würde Google sie sicher nicht einordnen wollen; Sie würden diese Information von jemandem wollen, der sich mit Babys auskennt. Ich habe keine große Lebenserfahrung mit schreienden Babys, aber meine Mutter schon. Ich bin mir sicher, dass ich als Baby viel geweint habe. Wenn wir also beide Artikel zu diesem Thema schreiben würden, würde Google den Unterschied zwischen meinem vorgetäuschten Fachwissen und ihrem tatsächlichen Fachwissen verstehen wollen und natürlich Inhalte von jemandem wie ihr höher einstufen wollen als meine oder KI.

Die Unterscheidung des Fachwissens in meinem obigen Beispiel ist weit von dem entfernt, was man heute unter SEO versteht. KI-Inhalte müssen nicht identifiziert werden. Sie kann diese Inhalte einfach nicht produzieren und wird wie ein wunder Punkt hervorstechen. Wenn die Anfrage von KI-Autoren beantwortet werden kann, kann (und wird) Google dies selbst tun und beabsichtigt, diese Antworten direkt in den Suchergebnissen anzuzeigen. Bei Abfragen, bei denen tatsächlich Fachwissen erforderlich ist, scheint die Betrachtung von Backlinks und Entity-Beziehungen nicht annähernd so wichtig zu sein.

Wie kann man also Fachwissen messen, wenn man Backlinks oder natürliche Sprachverarbeitung nicht für so nützlich hält?

Nutzerverhalten und Mustererkennung scheinen die Antwort zu sein.

Google wollte herausfinden, wie sich zufriedene Nutzer verhalten, wenn sie nach Antworten suchen. Sie maßen dieses Verhalten und diese Erfahrung und versuchten zu verstehen, wie es sich bei all den verschiedenen Arten von Anfragen, die jeden Tag auftauchen, unterscheidet. Dann baute Google sein Ranking-Gehirn neu auf, um zu verstehen, wie diese Muster aussehen und wie man objektiv erkennen kann, wann neue Artikel bessere Ergebnisse liefern könnten.

Dies bedeutet, dass Google diese unangekündigten Metriken und Muster beim Testen und Ranking von Seiten in Zukunft wahrscheinlich stärker berücksichtigen wird.

Das hört sich alles sehr viel an, und das ist es auch. Sie werden feststellen, dass niemand in der SEO-Branche in diesem Sinne darüber spricht. Das ist wirklich wichtig zu wissen, denn Sie können so ziemlich jeden ignorieren, der versucht, sich in dieser Sache wie ein Wissenschaftler zu verhalten, wenn er etwas anbietet, das auf Verschwörungstheorien hinausläuft. Ich bin mir sicher, dass die dummen Ratschläge von Leuten, die das Problem einfach nicht verstehen, in den nächsten Monaten kein Ende nehmen werden.

Wenn Sie Publisher oder Content Creator sind, gibt es keine andere Möglichkeit, sich von einem Google-Update zu erholen, als die Zeit zurückzudrehen und Inhalte zu erstellen, die die Leute wollen. Die Metriken und Informationen, die Google jetzt verwendet, wurden über ein Jahr lang gesammelt, und es gab keinerlei Kommunikation über Details, ob neue Daten gesammelt und in Echtzeit eingepflegt werden. Hinzu kommt, dass diese Daten den Publishern in keiner Weise zur Verfügung stehen.

So wie ich es sehe, gibt es zwei Dinge, die Google mit diesem Update für hilfreiche Inhalte erreichen will:

- Google hofft, dass sich diese Änderungen als unmöglich erweisen werden, da sie nicht gemessen oder auf objektive Weise verstanden werden können.

- Zwingen Sie die Webseiten dazu, Antworten zu geben, die auf dem Verständnis ihres Publikums und ihrem eigenen Fachwissen basieren.

Dies wirkt sich auch direkt auf alle Publisher aus, die Partnerunternehmen betreiben oder Autoren mit der Erstellung von Inhalten für ihre Webseite beauftragen. Die Wahrheit ist, dass Google glaubt, dass dies ein Teil des Problems ist: Webseiten, die Inhalte von Autoren enthalten, die keine Experten auf diesem Gebiet sind. Google hofft, dass Webseiten diese Methoden nur dann verwenden, wenn sie einen angemessenen Wert oder ein Niveau an Fachwissen bieten, das ohne sie nicht verfügbar ist.

Wenn Ihnen das Angst macht, sollten Sie bedenken, dass das Internet noch nicht in der Lage ist, das ideale Erlebnis zu bieten, das Google sich heute vorstellt. Die angekündigte Veränderung wird also wahrscheinlich zunächst nur punktuell auftreten, und die Fähigkeit zur Anpassung wird für alle gleich sein.